Publicidade

Meta Avança com IA: Llama 3.2 Permite Interação com Vozes de Celebridades e Análise de Imagens

A Meta acaba de lançar a nova versão do seu modelo de inteligência artificial, o Llama 3.2, trazendo grandes inovações ao mundo da IA. Uma das funcionalidades mais impressionantes é a capacidade de o assistente falar com as vozes de celebridades como John Cena, Judi Dench, Awkwafina, Keegan-Michael Key e Kristen Bell. Mas a revolução não para por aí. Além das vozes, o Llama 3.2 também introduz uma capacidade visual surpreendente, permitindo interpretar e editar imagens.

Neste artigo, exploramos como essas novidades podem impactar o uso da IA no cotidiano e em setores profissionais. Desde assistentes mais realistas até funcionalidades que facilitam a criação de conteúdos, o Llama 3.2 abre novas portas para a interação entre humanos e máquinas. Vamos detalhar os principais recursos dessa IA e o que o futuro nos reserva com essas inovações da Meta.

Vozes de Celebridades: A IA Falando como Famosos

A grande manchete do Llama 3.2 é, sem dúvida, a possibilidade de ouvir a IA falar com as vozes de grandes personalidades. A Meta investiu milhões para garantir que as vozes fossem o mais autênticas possível, criando uma experiência de interação extremamente realista. Ao conversar com o assistente, os usuários podem escolher ouvir John Cena, Judi Dench, Awkwafina e outros.

Mas o uso dessas vozes vem com certas limitações. As celebridades participantes impuseram restrições para evitar que suas vozes sejam usadas de forma inadequada, o que mostra uma preocupação crescente com a ética no uso de IA.

Atualmente, essas vozes estão disponíveis apenas em alguns países, incluindo Estados Unidos, Canadá, Austrália e Nova Zelândia. Mas há expectativas de expansão global em breve, permitindo que mais pessoas experimentem essa nova forma de interação com a IA.

Análise e Edição de Imagens com IA

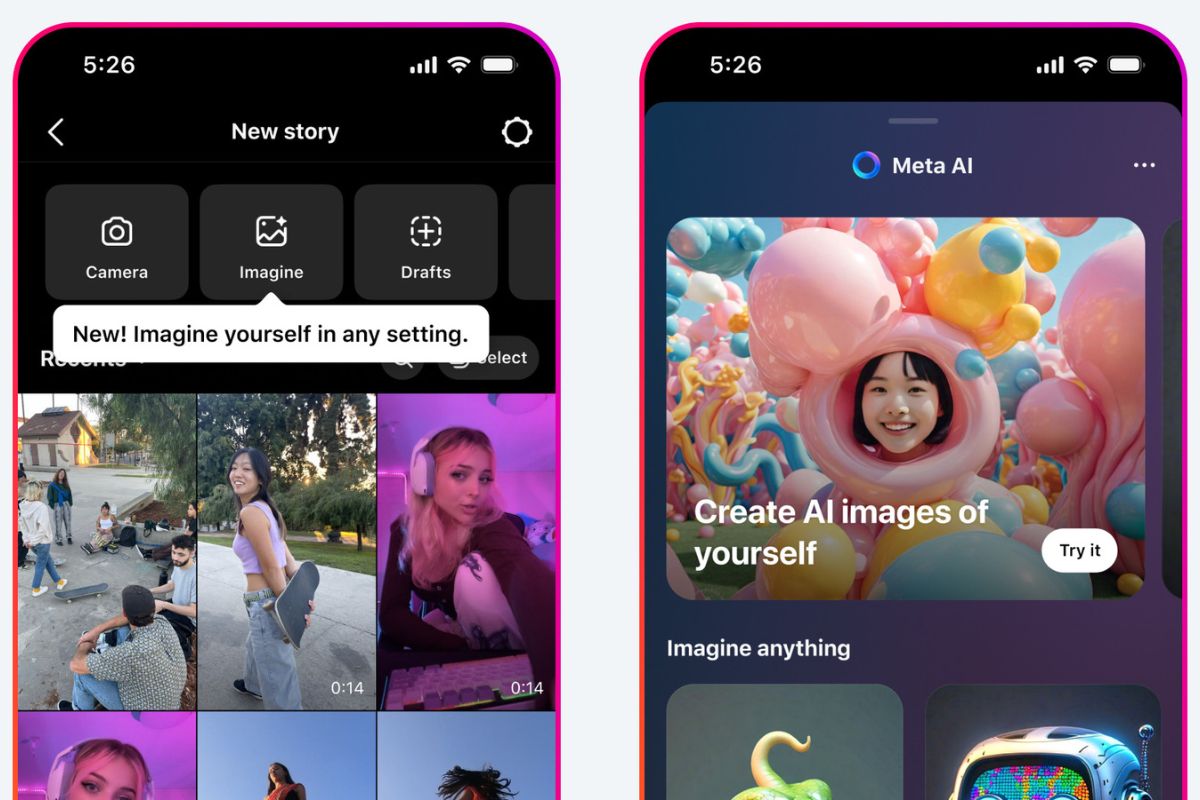

Além das vozes famosas, o Llama 3.2 traz uma capacidade visual que permite analisar imagens com precisão. Essa tecnologia vai muito além de simples reconhecimento de objetos; agora, a IA pode identificar espécies de animais, sugerir receitas a partir de fotos de alimentos e até editar imagens ao seu comando.

Imagine poder tirar uma foto de um local e pedir que a IA altere o fundo da imagem ou troque a cor de uma roupa. Com a introdução dessa tecnologia, usuários terão uma ferramenta poderosa para manipular imagens com um simples comando de voz.

Essa funcionalidade não se limita apenas a curiosidades. No mundo dos negócios, isso pode facilitar o trabalho de designers, fotógrafos e criadores de conteúdo. Pequenas empresas, por exemplo, poderão criar conteúdos visuais de alta qualidade com muito mais facilidade e velocidade.

Otimização para Dispositivos Móveis

Outro ponto importante do Llama 3.2 é sua otimização para dispositivos móveis. A Meta está permitindo que desenvolvedores criem aplicativos que utilizem a câmera dos smartphones para facilitar diversas ações. Isso significa que o poder de processamento e as funcionalidades da IA estarão na palma da sua mão, tornando mais simples e acessível o uso de IA em situações do dia a dia.

Por exemplo, com essa capacidade, os smartphones poderão automaticamente sugerir ações baseadas no que o usuário vê. Se você tirar uma foto de um objeto, o assistente pode sugerir compras online, oferecer informações detalhadas ou até recomendar ações criativas, como editar a foto ou criar um vídeo.

O Futuro da Interação com IA

Com o Llama 3.2, a Meta está moldando o futuro da interação homem-máquina, trazendo uma camada de personalização e funcionalidade que antes não existia. A inclusão de vozes reais e a capacidade de analisar e editar imagens criam um novo paradigma de interação, onde a tecnologia se aproxima ainda mais da experiência humana.

Essas inovações vão impactar não só o dia a dia dos usuários comuns, mas também profissionais de várias áreas. Criadores de conteúdo, pequenas empresas e desenvolvedores terão acesso a ferramentas poderosas que economizam tempo e aumentam a produtividade.

Posts Relacionados

Publicidade

Publicações Recentes

Comentários